gpu服务器系统,AI时代的计算引擎

时间:2024-11-26 来源:网络 人气:

GPU服务器系统:AI时代的计算引擎

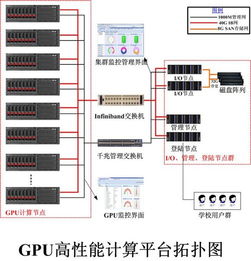

一、GPU服务器系统的组成

GPU服务器系统主要由以下几部分组成:

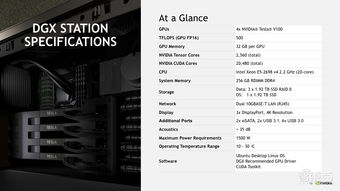

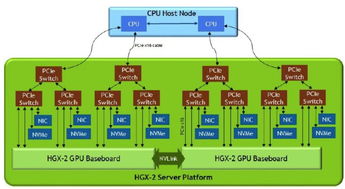

GPU加速卡:GPU加速卡是GPU服务器系统的核心,负责处理大量的并行计算任务。

服务器主板:服务器主板负责连接CPU、内存、硬盘等硬件设备,并提供电力供应。

CPU:CPU负责处理系统指令、调度任务等,与GPU协同工作,提高整体性能。

内存:内存用于存储程序运行时所需的数据,提高数据访问速度。

硬盘:硬盘用于存储系统文件、应用程序等数据。

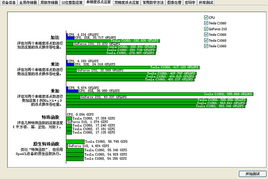

二、GPU服务器系统的工作原理

GPU服务器系统的工作原理如下:

用户通过应用程序向GPU服务器系统发送计算任务。

CPU接收任务,并根据任务类型将任务分配给GPU加速卡。

GPU加速卡接收任务,利用其强大的并行计算能力进行处理。

处理完成后,GPU加速卡将结果返回给CPU。

CPU将结果存储到内存或硬盘,供用户查询或进一步处理。

三、GPU服务器系统在AI领域的应用

GPU服务器系统在AI领域具有广泛的应用,以下列举几个典型应用场景:

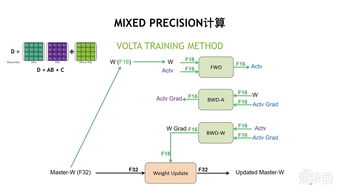

深度学习:GPU服务器系统可以加速深度学习算法的训练和推理过程,提高模型训练速度和准确率。

图像识别:GPU服务器系统可以快速处理大量图像数据,实现实时图像识别和分类。

语音识别:GPU服务器系统可以加速语音信号的采集、处理和识别,提高语音识别准确率。

自然语言处理:GPU服务器系统可以加速自然语言处理任务,如机器翻译、情感分析等。

四、GPU服务器系统的优势

与传统的CPU服务器系统相比,GPU服务器系统具有以下优势:

高性能:GPU服务器系统采用GPU加速卡,具有强大的并行计算能力,可以显著提高计算速度。

低功耗:GPU服务器系统在保证高性能的同时,具有较低的功耗,有利于降低数据中心运营成本。

可扩展性:GPU服务器系统可以根据需求灵活配置,满足不同规模的应用场景。

GPU服务器系统作为AI时代的计算引擎,在深度学习、图像识别、语音识别等领域发挥着重要作用。随着技术的不断发展,GPU服务器系统将更加成熟,为AI应用提供更加强大的支持。

相关推荐

教程资讯

教程资讯排行